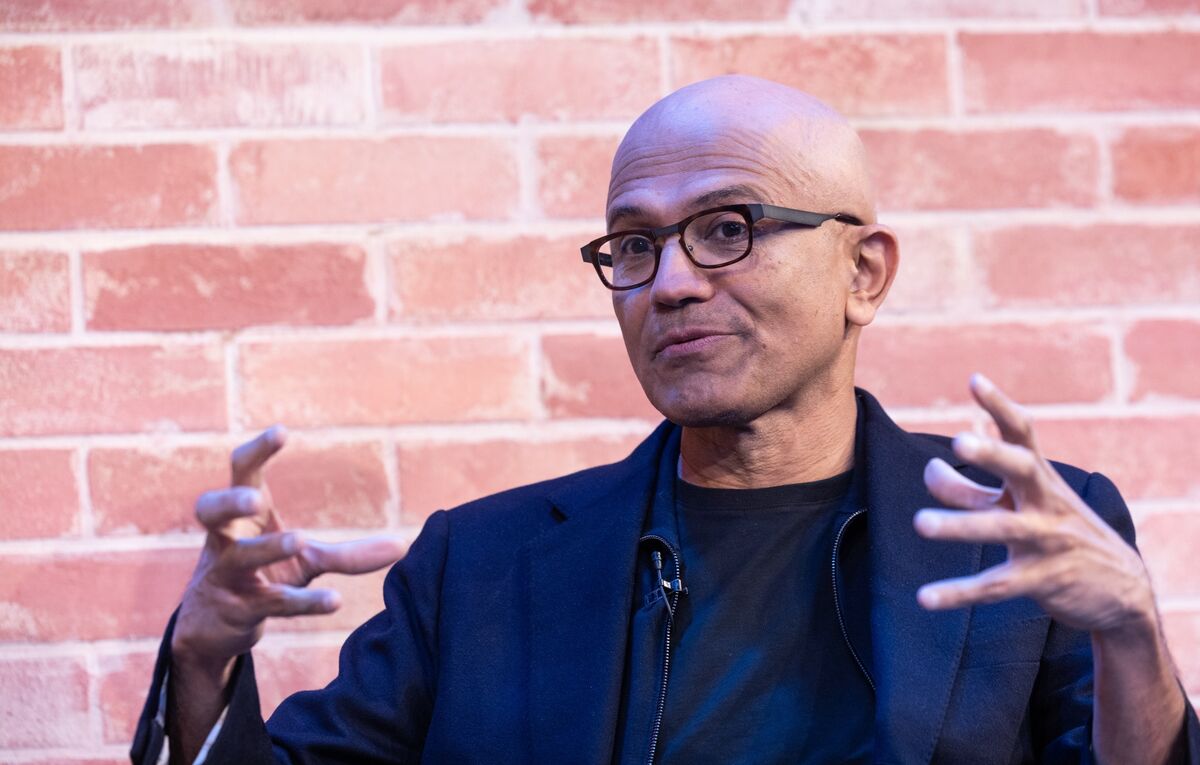

Satya Nadella: Bottleneck AI Bukan Chip, Tapi Listrik yang Kurang

CEO Microsoft Satya Nadella menggemparkan industri AI dengan pernyataan mengejutkan dalam podcast BG2 bersama CEO OpenAI Sam Altman pada 2 November 2025, mengungkap bahwa problem terbesar dalam ekspansi infrastruktur AI bukan lagi kelangkaan GPU atau kekurangan semiconductor, melainkan keterbatasan pasokan listrik untuk menjalankan hardware yang sudah dimiliki. Dalam revelasi yang mengubah narasi industri, Nadella mengonfirmasi Microsoft memiliki ribuan GPU Nvidia terbaru yang terpaksa menganggur di gudang karena pusat data tidak memiliki cukup daya listrik dan sistem pendingin untuk mengoperasikannya, menandai pergeseran paradigma dari "kelangkaan komputasi" ke "kelangkaan energi" sebagai faktor pembatas utama dalam persaingan AI global antara Amerika Serikat dan China.

"Masalahku Bukan Supply Chip, Tapi Tempat untuk Mencolokkannya"

Dalam wawancara yang digelar oleh Brad Gerstner, host podcast BG2 dan CEO Altimeter Capital, Nadella merespons pertanyaan tentang apakah ia setuju dengan prediksi CEO Nvidia Jensen Huang yang menyatakan tidak akan ada kelebihan komputasi dalam 2-3 tahun ke depan. Jawaban Nadella mengungkap realitas yang berbeda dari yang diprediksi industri: "The biggest issue we are now having is not a compute glut, but it's power—it's sort of the ability to get the builds done fast enough close to power. So, if you can't do that, you may actually have a bunch of chips sitting in inventory that I can't plug in. In fact, that is my problem today. It's not a supply issue of chips; it's actually the fact that I don't have warm shells to plug into."

Istilah "warm shells" yang disebutkan Nadella merujuk pada struktur pusat data, yaitu gedung kosong yang sudah dilengkapi semua infrastruktur yang diperlukan seperti pasokan listrik, sistem pendingin, dan infrastruktur air yang siap untuk produksi langsung. Masalahnya bukan ketersediaan gedung atau real estate, tetapi kendala infrastruktur fundamental: kapasitas jaringan listrik yang tidak mampu memenuhi kebutuhan daya untuk beban kerja AI modern. Microsoft, sebagai salah satu hyperscaler terbesar dunia dengan investasi miliaran dolar dalam infrastruktur AI, kini menghadapi situasi paradoks dimana mereka memiliki hardware canggih tetapi tidak bisa menggunakannya.

Sam Altman, yang duduk bersama Nadella dalam wawancara tersebut, memberikan perspektif yang sedikit lebih optimistik tentang prospek masa depan. Altman memprediksi bahwa "kelebihan daya komputasi pasti akan muncul" dalam jangka waktu 2-6 tahun ke depan, mengindikasikan bahwa kekurangan daya saat ini adalah hambatan sementara yang pada akhirnya akan teratasi seiring dengan investasi dalam infrastruktur pembangkit listrik. Namun, prediksi Altman ini juga secara implisit mengakui bahwa dalam jangka pendek hingga menengah, kendala energi akan terus menjadi faktor pembatas utama untuk ekspansi AI.

Untuk software developer AI dan pengembang aplikasi AI, situasi ini memiliki implikasi yang mendalam. Hambatan energi bukan hanya masalah operasional untuk penyedia cloud, ini adalah kendala strategis yang akan membentuk seluruh lintasan pengembangan AI. Perusahaan yang merencanakan untuk menerapkan aplikasi AI skala besar perlu memperhitungkan tidak hanya biaya komputasi, tetapi juga ketersediaan energi dan keberlanjutan dari infrastruktur yang mendasarinya. Ini juga menjelaskan mengapa Microsoft dan raksasa teknologi lainnya agresif berinvestasi dalam reaktor nuklir modular kecil dan sumber energi terbarukan sebagai solusi jangka panjang untuk permintaan daya.

Krisis Kepadatan Daya: Lompatan 100 Kali dalam Konsumsi Daya Rack

Nadella menjelaskan bahwa inti masalahnya adalah tantangan kepadatan daya yang belum pernah terjadi sebelumnya yang belum pernah dihadapi industri. Menggunakan GPU pusat data Nvidia sebagai contoh, total konsumsi daya rack telah melonjak hampir 100 kali lipat dari generasi Ampere ke arsitektur Blackwell terbaru. Setiap iterasi GPU baru memang memberikan performa lebih besar dan peningkatan efisiensi dalam hal performa-per-watt, tetapi konsumsi daya absolut per rack terus meningkat secara dramatis, sementara sistem pengiriman daya dan infrastruktur pendingin tidak bisa berkembang dengan kecepatan yang sama.

Situasi ini menciptakan ketidakseimbangan struktural dalam pembangunan infrastruktur AI global. Performa GPU tumbuh secara eksponensial mengikuti lintasan Hukum Moore, tetapi ketersediaan daya, kapasitas pendingin, dan lahan yang sesuai untuk pembangunan pusat data tumbuh secara linear. Hasilnya adalah apa yang Nadella sebut sebagai "bentuk lain dari surplus komputasi", bukan kelebihan pasokan hardware dalam pengertian tradisional, tetapi hardware yang tidak bisa dimanfaatkan karena kendala infrastruktur. Tom's Hardware melaporkan bahwa situasi ini sudah menyebabkan tagihan listrik konsumen melonjak di wilayah dengan konsentrasi pusat data yang tinggi, menunjukkan dampak nyata dari permintaan infrastruktur AI terhadap konsumen rata-rata.

Industri sedang bereksperimen dengan berbagai solusi teknologi untuk mengatasi tantangan kepadatan daya ini. Sistem pendingin cair, yang sebelumnya dianggap over-engineering untuk sebagian besar aplikasi pusat data, kini menjadi kebutuhan untuk kluster AI berkepadatan tinggi. Sistem distribusi daya arus searah tegangan tinggi sedang diterapkan untuk mengurangi kerugian transmisi. Sistem energi modular yang memungkinkan penskalaan fleksibel sedang diuji. Namun, semua inovasi ini memerlukan investasi modal besar dan timeline penerapan yang panjang, diukur dalam tahun, bukan bulan.

Yang sangat mengkhawatirkan adalah kesenjangan yang melebar antara lintasan pertumbuhan komputasi dan siklus pengembangan infrastruktur energi. Pembangunan pusat data dan peningkatan jaringan listrik biasanya memakan waktu 5-10 tahun dari perencanaan hingga operasional, sementara performa GPU dan ukuran model AI berlipat ganda setiap 12-18 bulan. Ketidakcocokan dalam siklus pengembangan ini menciptakan kelambatan yang persisten yang sulit diatasi tanpa pemikiran ulang fundamental tentang bagaimana kita mendekati infrastruktur AI.

Strategi Dual Factory: Respons Microsoft terhadap Hambatan Energi

Menghadapi realitas kendala energi, Nadella menguraikan pendekatan strategis Microsoft yang ia sebut sebagai membangun dua "pabrik" secara bersamaan untuk memaksimalkan output kecerdasan per unit energi yang dikonsumsi. Pabrik pertama adalah "Token Factory", infrastruktur komputasi yang mendasari mencakup hardware (GPU, server, jaringan), perangkat lunak sistem (virtualisasi, orkestrasi), dan kemampuan manajemen beban kerja. Ini adalah infrastruktur pusat data tradisional yang dikenal kebanyakan orang, tetapi dioptimalkan khusus untuk beban kerja generasi token AI.

Pabrik kedua adalah "Agent Factory", ekosistem perangkat lunak tingkat atas yang mencakup model AI, framework agentic, lapisan aplikasi, dan alat developer. Poin Nadella adalah bahwa mengoptimalkan hanya lapisan hardware tanpa optimalisasi yang sesuai di lapisan perangkat lunak tidak cukup untuk mengatasi kendala energi. Metrik kunci bukan mengurangi biaya per unit komputasi (yang selama ini menjadi target optimalisasi utama), tetapi meningkatkan "kecerdasan per unit energi", yaitu berapa banyak output AI yang berguna yang bisa dihasilkan per kilowatt-hour yang dikonsumsi.

Pendekatan ini mencerminkan kesadaran industri yang lebih luas bahwa efisiensi energi harus menjadi perhatian utama dalam pengembangan AI, bukan pertimbangan tambahan. Altman juga menekankan pentingnya potensi AI untuk penemuan ilmiah dalam wawancara tersebut, dengan menyatakan: "If we can truly enable AI to conduct scientific research, then in a sense, that would be a real game changer." Konteksnya adalah bahwa terobosan penemuan ilmiah, termasuk dalam teknologi pembangkitan dan penyimpanan energi, dapat secara fundamental mengubah ekonomi energi dan menghilangkan hambatan saat ini.

Altman juga memberikan pujian tinggi untuk dukungan awal Microsoft yang sangat penting bagi kesuksesan OpenAI: "Without Microsoft, especially Satya Nadella's early and steadfast belief, we wouldn't be where we are today. I think there were very few people willing to take such a bet back then." Pernyataan ini sangat signifikan mengingat kemitraan Microsoft-OpenAI baru-baru ini mengalami restrukturisasi besar dengan komitmen $500 miliar, menunjukkan bahwa meskipun ada tantangan energi, kedua perusahaan tetap berkomitmen untuk pembangunan AI jangka panjang.

Untuk pengembang aplikasi AI, konsep dual factory ini memberikan kerangka kerja untuk berpikir tentang optimalisasi. Aplikasi yang dirancang dengan efisiensi energi dalam pikiran, misalnya dengan caching cerdas, distilasi model, atau strategi inferensi adaptif, akan memiliki keunggulan kompetitif di masa depan yang terbatas energi. Ini bukan hanya tentang mengurangi tagihan cloud, tetapi tentang memastikan akses berkelanjutan ke kemampuan AI karena energi menjadi sumber daya yang semakin berharga.

(Burung Hantu Infratek / Berbagai Sumber)

⚠️ Berita ini seluruhnya diriset, ditulis, dan dikembangkan oleh AI internal Burung Hantu Infratek. Mohon maaf apabila terdapat ketidakakuratan pada data aktual.

Berita Terkait Microsoft dan AI Infrastructure

💰 Microsoft dan OpenAI Restrukturisasi Kemitraan Senilai $500 Miliar

🌐 Microsoft Luncurkan Edge Copilot Mode Dua Hari Setelah OpenAI Atlas: Perang Browser AI Memanas

🤖 Sam Altman: OpenAI Miliki Peneliti AI Sejati pada 2028

😨 Satya Nadella Takut Microsoft Punah Gara-Gara AI

Sumber dan Referensi

[1] Microsoft CEO Satya Nadella on 'new' challeneges in AI - Times of India

[3] Microsoft CEO: The Real AI Bottleneck Is Energy, Not Compute - Kontronn

[4] Inside the Data Centers That Train A.I. and Drain the Electrical Grid - The New Yorker

[5] Rising energy prices put AI and data centers in the crosshairs - TechCrunch